OpenAI、「GPT-4o」を発表、ChatGPTで使える最新AIモデル、以前のモデルより高速で回答が生成

更新日:2024年05月15日

公開日:2024年05月15日

米国時間2024年5月13日、OpenAIはオンラインで新製品発表会を開催。そこで最新AIモデル「GPT-4o」を発表した。GPT-4oはAIと音声によるリアルタイムの対話が可能になるほか、画像やテキストに関する回答も高速化している。

目次

GPT-4oとは

GPT-4oは、テキストや音声、画像を処理できるChatGPTの最新モデルのこと。読み方はGPT-4oは「ジーピーティーフォーオー」。GPT-4oの「o」は、ラテン語で「すべて」を意味する「omni(オムニ)」の「o」に由来する。

「GPT-4 Turbo」と比較すると、同じ性能を持ちながら、より速く動き、テキスト、音声、画像の理解力も大幅に向上している。英語やプログラムコードの処理能力はGPT-4 Turboと同等のようだが、他言語のテキストに関しては大幅な改善が見られる。

GPT-4oの利用方法

GPT-4oは、ChatGPTの有料サブスクリプションに加入せずとも無料で利用可能になる予定とのこと。

GPT-4oの特長

GPT-4o以前は、音声モードを使ってChatGPTと話すと、GPT-3.5では平均2.8秒、GPT-4では5.4秒の時間がかかっていた。音声モードは、3つの異なる部分で動いているという。最初の部分は声を文字に変え、次にGPT-3.5かGPT-4がその文字を使って答えを作り、最後の部分はその答えをまた声に戻す。

このやり方では、主に使われるGPT-4が声の高さや背景の音、笑い声などの細かい情報をうまく拾えないため、限界があった。GPT-4oでは、文字や画像、音声をすべて、一つの新しいモデルで学習。これは、すべての情報を一つの大きなネットワークが処理するということだ。

GPT-4oはこれらの異なる種類の情報を一緒に扱える初めてのモデル。まだこのモデルのできることや限界を完全には分かっていない。

GPT-4oの特長をGPT-4oに尋ねた

GPT-4oの特長をGPT-4oに尋ねたところ、以下の回答が生成された。

- 多機能モデル: GPT-4oは、テキスト、視覚、音声の全てのモダリティを一つの統一モデルで処理します。これにより、複雑なタスクをシームレスにこなすことができます。

- 高性能: 従来のベンチマークで測定された結果によれば、GPT-4oはテキスト、推論、コーディングにおいて、GPT-4 Turboと同等のパフォーマンスを発揮します。

- 新しい最高水準: GPT-4oは、多言語対応、音声認識、視覚解析の分野で新たな基準を設定します。これにより、より広範な用途での活用が期待されます。

- 統合された処理: GPT-4oでは、異なる種類の情報を単一のニューラルネットワークで処理することで、効率と正確さが向上しています。

- 無料利用: ChatGPTの有料サブスクリプションに加入しなくても、GPT-4oを無料で利用できるようになります。これにより、より多くの人々がこの技術を活用できるようになります。

- 改善された対話速度: 音声モードを使用した場合でも、従来のモデルよりも迅速に応答が可能です。これは、音声からテキストへの変換やテキストから音声への変換のプロセスが効率化されているためです。

- 感情と表現の向上: GPT-4oは、音調や複数の話者、背景雑音をより良く認識し、笑い声や歌、感情の表現も可能になっています。

GPT-4oの能力と評価

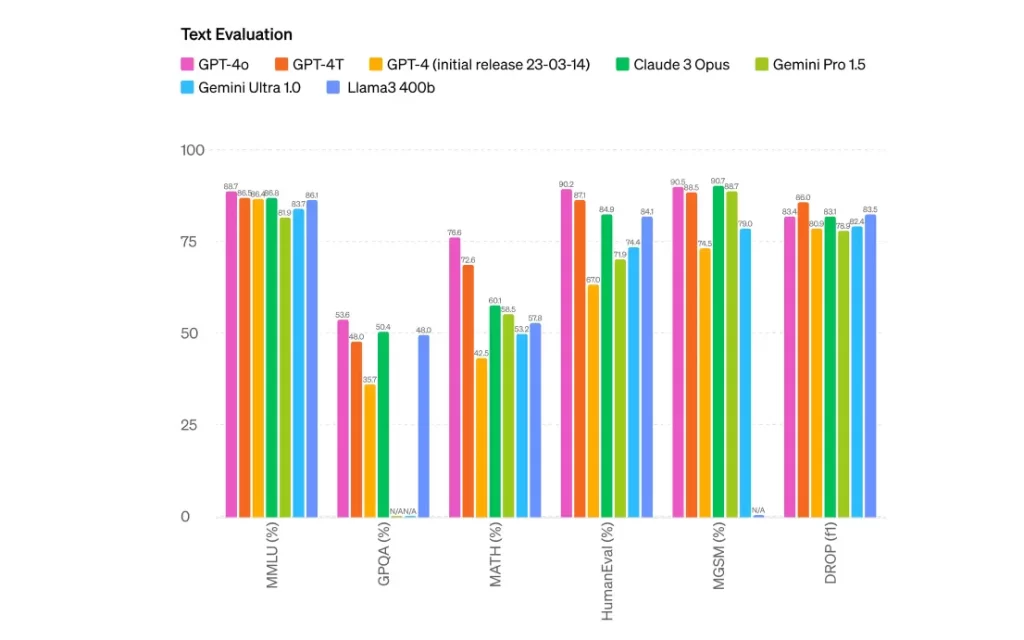

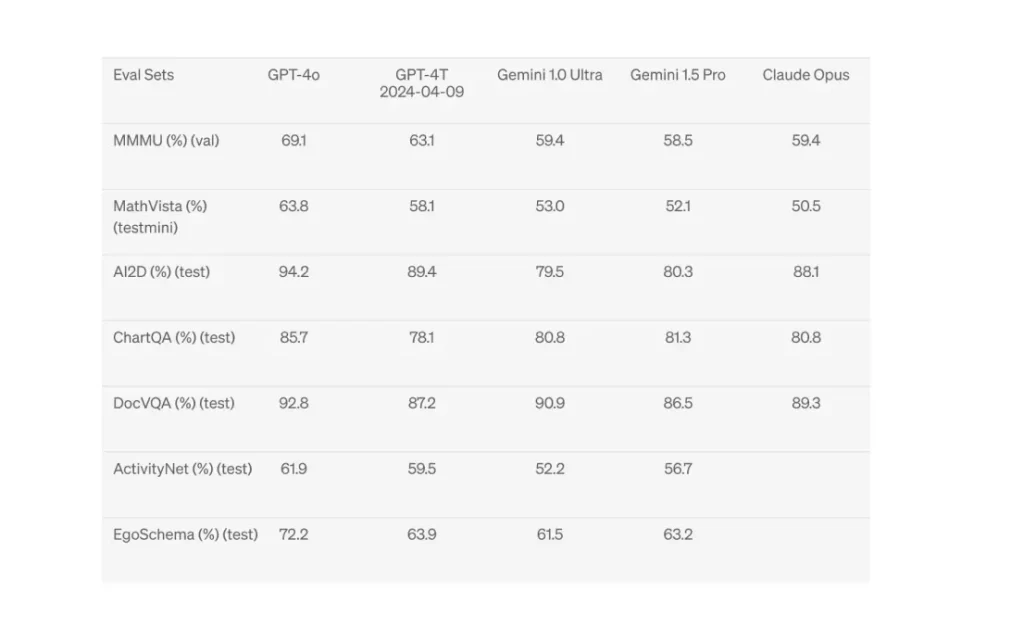

GPT-4oとベンチマークしているモデルを比較したところ、GPT-4oはテキスト、推論、コーディング能力においてGPT-4 Turboと同等のパフォーマンスを示しながら、多言語、オーディオ、ビジョン機能において最高のパフォーマンスを示した。

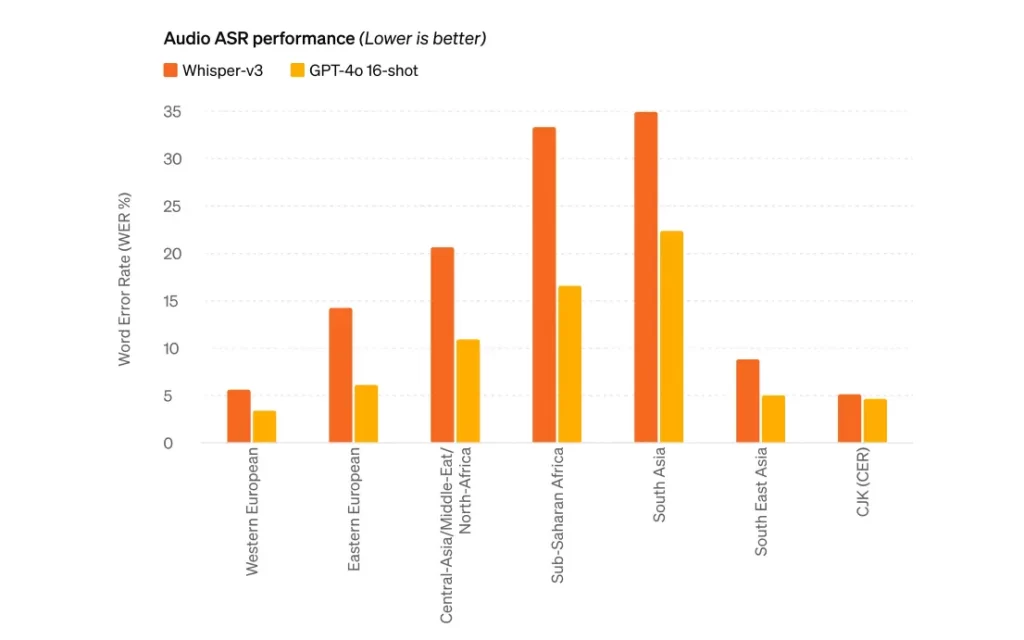

言語ごとの音声認識

言語ごとの音声認識性能は、以前使われていた「Whisper-v3」と比較。英語はもちろん、すべての言語でGPT-4oの方が優れた成績を見せている。

将来的には、より自然なリアルタイムの音声会話や、リアルタイムのビデオを通じてChatGPTと対話する機能が追加される予定。

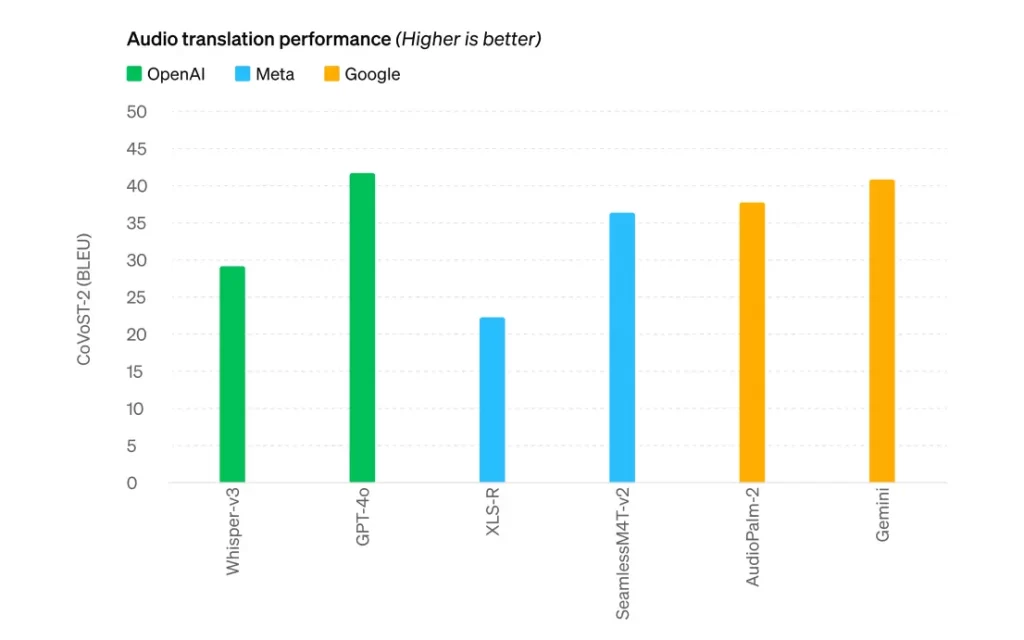

音声翻訳

音声翻訳の性能においGPT-4oは、トップレベルを達成。ベンチマークにしているWhisper-v3をはじめ、各社よりも優れている。

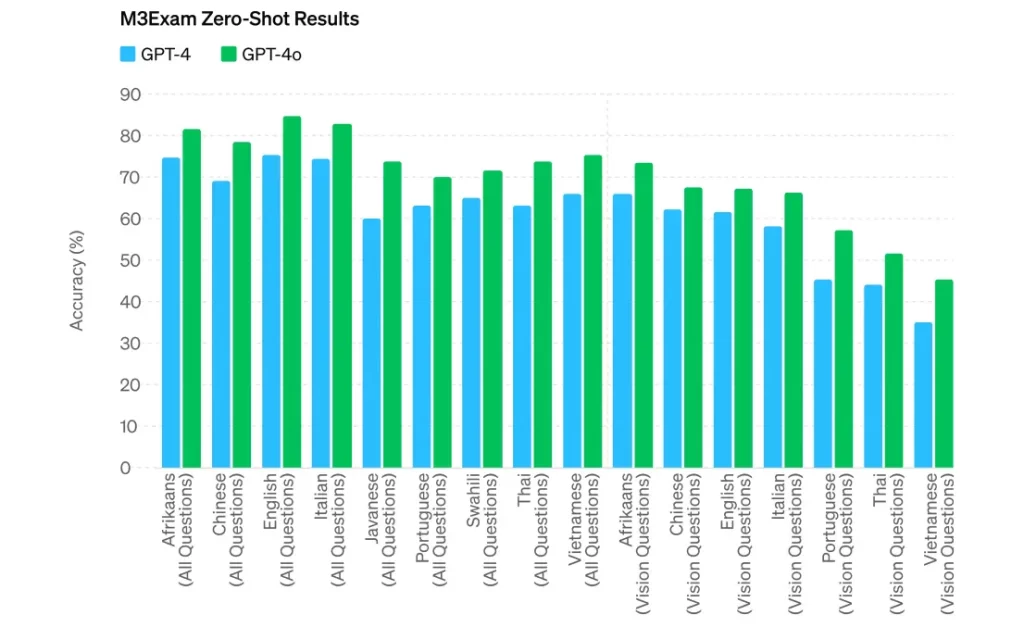

多言語と画像

M3Exam(Multilingual, Multimodal, Multilevel Benchmark Exam)は多言語と画像を評価するためのもの。これは、他の国の標準テストから集めた選択式の問題で構成されており、図や表が含まれることもある。

このベンチマークでは、すべての言語でGPT-4oがGPT-4よりも優れた成績を示している。

画像認識

画像認識のテスト結果では、すべての項目でGPT-4 Turboや他社のLLMよりも優れた成績を示している。

GPT-4oの今後

GPT-4oは、ディープラーニングの新しい進化で、使いやすさを重視したもの。過去2年間、効率を高めるために多くの努力をしてきた。その成果として、GPT-4の性能をより多くの人が利用できるようにした。今日から、一部の人々がGPT-4oを試せるようになる。

GPT-4oのテキストと画像機能は、今日からChatGPTで使えるように。GPT-4oは無料で使えるほか、Plusユーザーは5倍のメッセージ制限で利用可能。今後数週間以内に、ChatGPT Plusのユーザー向けに、音声モードの新しいバージョンも公開予定。

開発者は、APIを通じてGPT-4oのテキストと画像機能を利用可能。GPT-4oは、GPT-4 Turboと比べて2倍速く、価格は半分、レート制限は5倍高く設定。今後数週間以内に、信頼できるパートナーの小グループ向けに、新しいオーディオとビデオ機能も提供予定。